Cet homme a trouvé plein de problèmes sur son site grâce à un audit SEO

Si vous êtes un habitué de ce blog, vous savez ô combien le SEO peut être polymorphique. Mais l’un de ses aspects les plus essentiels, en parallèle de la sémantique, c’est la technique. Un bon référencement web ne peut se faire sans une solide technique. Et comment s’assurer que celle-ci tienne la route ? Par un audit.

Bon, elle était facile cette devinette, tout était déjà dans le titre. L’objectif de cet article est donc de voir ensemble pourquoi un audit technique de votre site web peut être utile pour votre référencement, et comment faire un audit SEO de la manière la plus efficace possible dans le cadre d’une stratégie de marketing en ligne.

Pourquoi faire un audit technique en SEO ?

Vous n’êtes pas sans savoir que les robots de Google ne perçoivent pas votre site comme un humain le ferait. Il est donc quasiment impossible de déterminer si votre site web est pleinement conforme au SEO en vous contentant de visiter les pages comme le ferait le premier visiteur venu. Vous devez utiliser un certain nombre d’outils, notamment des crawlers qui agissent comme le feraient les robots de Google.

Il y a malgré tout une bonne nouvelle : vous n’êtes pas obligés de réinventer la roue à chaque fois. En suivant une méthodologie bien précise, qui s’articule autour des guidelines de Google, vous pouvez facilement repérer les plus gros problèmes. Attention, cela ne signifie pas que vous devez faire un travail mécanique sans aucune réflexion ! Si le sur mesure est essentiel pour ne pas passer à côté de la grosse erreur qui change tout à votre référencement, appliquer une méthode permet d’éviter de trop vous disperser dans des détails infinis.

Mais un audit technique, ça ne fait pas tout. Ce n’est qu’un moyen d’accéder à une fin. Et la finalité, c’est identifier et mettre en place les solutions concrètes qui permettront à terme d’améliorer votre SEO. Sans audit, pas d’optimisation technique applicable… Et sans cela, positionner votre site web sur Google sera nettement plus hasardeux, puisque vous partirez avec un handicap.

Comment réaliser votre audit SEO ?

Il n’existe pas de site web parfait, encore moins avant un audit. S’il y a bien une inquiétude que vous ne pouvez pas avoir, c’est de ne rien trouver pendant ce travail. Les consultants de Foxglove n’ont jamais été confrontés à une situation où ils ne trouvaient rien à redire, et ce malgré leur grand âge expérience significative. Toutefois, un audit technique ne se fait pas n’importe comment. Il y a tellement de choses à faire que vous prenez le risque de vous éparpiller. C’est pour cette raison que faire appel à une agence SEO est souvent la solution la plus simple et la plus efficace.

L’analyse du SEO technique d’un site web se fait selon un principe d’entonnoir. Il existe des points plus bloquants que d’autres. L’objectif est donc de prioriser ceux qui nuisent le plus à votre référencement, puis progressivement de se concentrer sur ce qui relève plus de l’optimisation que de la correction. Cet entonnoir se construit donc sous cette forme : vérifier l’indexabilité des URL, puis la bonne crawlabilité du site, et enfin optimiser la qualité perçue par les Googlebots.

Etape 1 : l’indexabilité

En SEO, on dit d’une page qu’elle est indexable quand elle correspond à ces quatre critères :

- Elle répond dans un code HTTP 200

- Elle ne porte pas de balise NoIndex

- Elle n’a pas de balise canonique pointant vers une autre page

- Elle est au format HTML et ne dépend pas exclusivement du JavaScript

Afin de vous donner les bonnes pratiques en matière d’indexation, revenons en détail sur chacun de ces aspects.

Les codes HTTP

Un code HTTP est une sorte de message envoyé par un serveur pour indiquer au navigateur (ou au robot de crawl) si sa demande a été traitée avec succès ou s’il y a eu une erreur. Si le dernier cas s’applique, il existe toute une variété de codes permettant de donner une information plus précise.

Ainsi une redirection permanente (code 301) ou une ressource non trouvée (code 404) ne sont pas traités de la même manière par Google. Toutefois, le résultat reste le même : ces pages ne sont pas indexables.

Les balises NoIndex

Ce type de balise est assez parlant puisque tout est dans leur nom. Il s’agit d’une instruction, que l’on peut ajouter dans la section <head> du code HTML d’une page web pour indiquer aux moteurs de recherche de ne pas indexer cette page. Très pratique sur les preprod ou le back office, il en va autrement si celles-ci figurent sur une page stratégique…

Les balises canoniques

Celle-là est un peu plus complexe à comprendre. Une balise canonique est utilisée pour indiquer aux moteurs de recherche quelle est l’URL principale d’une page, s’il en existe d’autres très similaires.

Prenons un exemple. Vous avez un article de blog et celui-ci a tellement de succès qu’il a reçu plusieurs pages de commentaires. C’est problématique pour votre référencement : comme le texte de l’article réapparaît à chaque page, les différentes URL de pagination contiennent un contenu trop similaire. Or Google pénalise le duplicate.

Une balise canonique est donc installée sur chaque page de commentaire, pour signifier aux robots que cette pagination ne doit pas être prise en compte et que le contenu original est l’article de blog sans commentaires.

Etape 2 : la crawlabilité

La crawlabilité consiste à s’assurer que les pages stratégiques puissent être facilement explorées par Google. Il ne suffit pas qu’une page soit indexable pour référencer celle-ci. Afin que les robots puissent prendre connaissance de son existence, des liens internes doivent pointer vers celle-ci. Plus une page est stratégique pour votre référencement, plus elle doit recevoir des liens internes.

Google et les autres appliquent la notion de budget crawl. En fonction de l’importance de votre site, ils vous accordent un certain temps d’exploration. Si celui-ci est dépassé, ils arrêtent de parcourir vos contenus. Il est donc important de rendre vos pages les plus importantes très facilement accessibles.

Le maillage interne

Si vous avez sélectionné des pages spécifiques pour travailler vos mots-clés, ce qui est bien sûr une bonne pratique, vous devez vous assurer que son maillage interne soit bien optimisé. Définissons tout d’abord précisément ce que c’est. Un maillage interne désigne l’architecture de l’ensemble des liens internes d’un site donné. Google calcule dans son algorithme la manière dont sont structurés les liens de votre site. Plus une page reçoit des liens depuis d’autres pages internes, plus il en tient compte.

Comme vos contenus SEO doivent être mis en avant, il existe une méthode très simple permettant de faire pointer un maximum de liens vers eux : lier vos URL directement depuis le menu et le footer. Cela vous permet de recevoir des liens internes depuis l’ensemble de votre site.

Les pages orphelines

Un site web a quelque chose de très organique, dans le sens où il évolue comme un être vivant. Ce qui est vrai à un moment donné peut changer du jour au lendemain, au gré des mises à jour et changements stratégiques de ses gérants. C’est pour cette raison qu’il y a souvent des pages orphelines qui apparaissent.

Une page orpheline ne reçoit aucun lien interne du site sur lequel elle est présente. Comme elle n’est reliée à aucune autre page du site, les crawlers des moteurs de recherche ne peuvent y accéder et en prendre connaissance. Ce ne sont pas toujours de nouvelles pages, parfois ce sont aussi des URL historiques qui disparaissent lors de la réorganisation d’un site web.

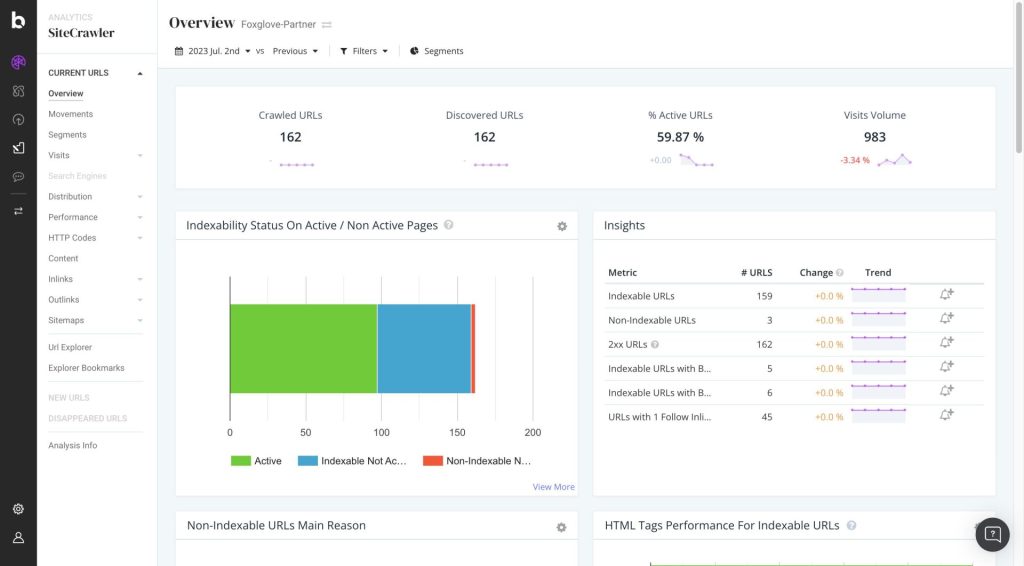

Avec un outil comme Botify, il est possible de repérer les pages orphelines si elles ont reçu des visites trackées par Google Analytics. Cette analyse est parfois source de surprise : des pages parfaitement adaptées à votre stratégie SEO ne sont plus maillées et doivent donc être mises en avant à nouveau.

Quelques astuces pour améliorer votre budget crawl

Afin d’optimiser votre crawlabilité, et donc votre référencement naturel, il existe quelques aspects techniques sur lesquels focaliser votre attention :

- Vérifier que le fichier robots.txt ne bloque pas des pages importantes

- S’assurer que le fichier Sitemap contienne toutes les pages à référencer

- Démailler toutes les redirections pour ne pas faire perdre de temps à Google

- Optimiser le niveau de profondeur avec des pages proches de la home

- Avoir un fil d’Ariane, aussi bien sous forme visible que via des données structurées

- Analyser les logs de votre site si celui-ci a plus de 10 000 URLs

- Configurer des balises hreflang conformes pour les sites multilingues

Vous l’aurez compris, il y a beaucoup de choses à penser. Dans le cadre de notre article, nous ne survolons que certains aspects. Mais vous pouvez retrouver notre guide complet sur le SEO technique pour aller plus loin.

Comme un site évolue dans le temps, un peu comme un organisme vivant, vous trouverez toujours de nouvelles corrections à apporter tout au long de vos crawls.

Etape 3 : la qualité perçue

Une fois que vous vous êtes assuré que vos pages soient bien indexables et crawlables, des actions qui sont plus de l’ordre de l’optimisation doivent être faites. Google utilise un ensemble de signaux objectifs pour déterminer si votre site est d’un niveau de qualité suffisant. Penchons-nous sur chacun de ces points !

Les balises Méta

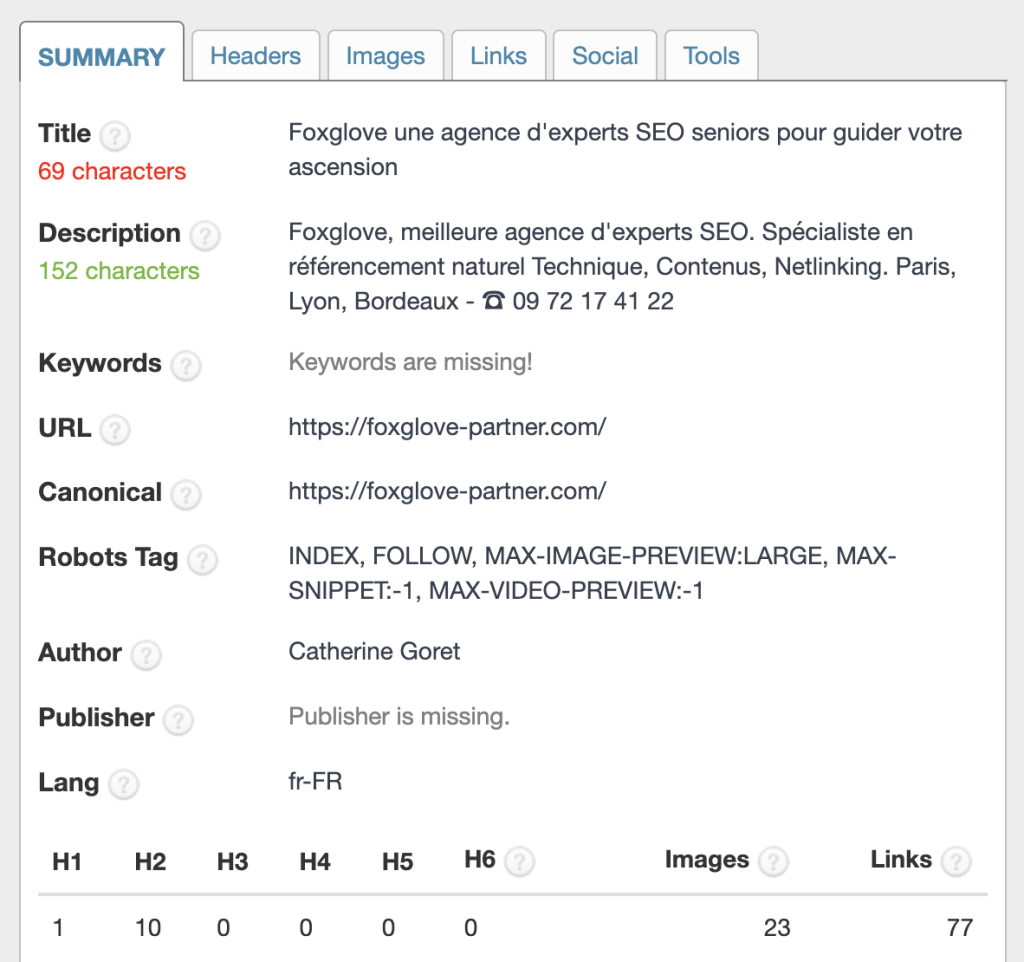

Dans le cadre d’un audit SEO, vous devez analyser des zones du site avec plus d’attention que d’autres, car Google ne leur accorde pas la même importance. Les balises Méta sont indispensables pour travailler vos mots-clés, tant elles ont un impact sur le positionnement de votre domaine.

Il existe deux types de balise : la Title et la Méta Description. Les deux sont directement visibles sur les résultats de recherche. La Title est le titre bleu cliquable, tandis que la Méta Description est le petit texte descriptif en bas.

Assurez-vous de bien faire figurer vos mots-clés dans la Title. Vous aiderez ainsi les moteurs de recherche à mieux comprendre sur quel mot-clé vous positionner. C’est la balise la plus importante pour travailler vos mots-clés.

La Méta Description, elle, n’a pas d’impact sur les positions mais sur le taux de clic. Elle demeure importante, car elle permet aux utilisateurs d’avoir un contexte. Avec les bons arguments vous pouvez générer un meilleur trafic organique tout en vous différenciant de vos concurrents.

La compatibilité mobile

Vous devez vous assurez que le design soit bien adapté à une vue mobile. Un smartphone est un écran nettement plus petit qu’un ordinateur et des doigts malhabiles remplacent le curseur. La police de vos textes doit donc être d’une taille suffisamment visible et vous devez vous assurer que vos liens et boutons soient accessibles sans approximation. Aujourd’hui la plupart des sites tiennent compte de ces spécificités avec un responsive design, autrement dit une mise en forme qui s’adapte à la taille de l’écran.

Le temps de chargement

Votre site doit charger vite et bien. En d’autres mots, votre serveur et votre code source doivent être suffisamment optimisés pour permettre un téléchargement rapide des ressources : les fichiers HTML et CSS, les images, les scripts… L’intégralité de votre contenu doit se charger en moins de 2 secondes, sinon vous risquez une pénalité. L’idéal serait de passer sous les 500 millisecondes.

La sécurité du site

Google accorde de plus en plus d’importance à la sécurité d’un site pour déterminer s’il est prudent de lui donner un bon référencement. Sans que cela ne soit un prérequis indispensable (malgré tout ce que l’on peut entendre à ce sujet), assurez-vous que votre domaine soit en HTTPS et bien configuré en ce sens. Si votre certificat SSL n’est pas valide, cela peut grandement vous handicaper. Il est donc préférable de ne rien faire du tout que de mal faire. Mais pour un site E-commerce par exemple, le HTTPS c’est aussi donner confiance à vos clients…

Quels outils SEO utiliser ?

Tous nos conseils sont bien gentils, mais comment accéder à ces informations ? Afin de vous aider à faire votre audit technique et concentrer votre analyse sur les points les plus importants, ceux qui vous rendront visible sur les mots-clés visés, nous allons vous présenter un certain nombre d’outils qui vous aideront. Même s’ils ont souvent des versions d’essais, une partie de ces outils ne sont pas gratuits. Votre stratégie SEO doit donc s’accompagner d’un certain budget. De quoi donner tort à ceux qui disent que le référencement naturel ne coûte rien…

Trouver le bon crawler

C’est probablement l’outil le plus important du référenceur. Un crawler se comporte comme les moteurs de recherche, en parcourant votre domaine de la même manière que le ferait un Googlebot par exemple. Il en existe de deux types : ceux qui s’exécutent depuis votre ordinateur, et ceux depuis un serveur.

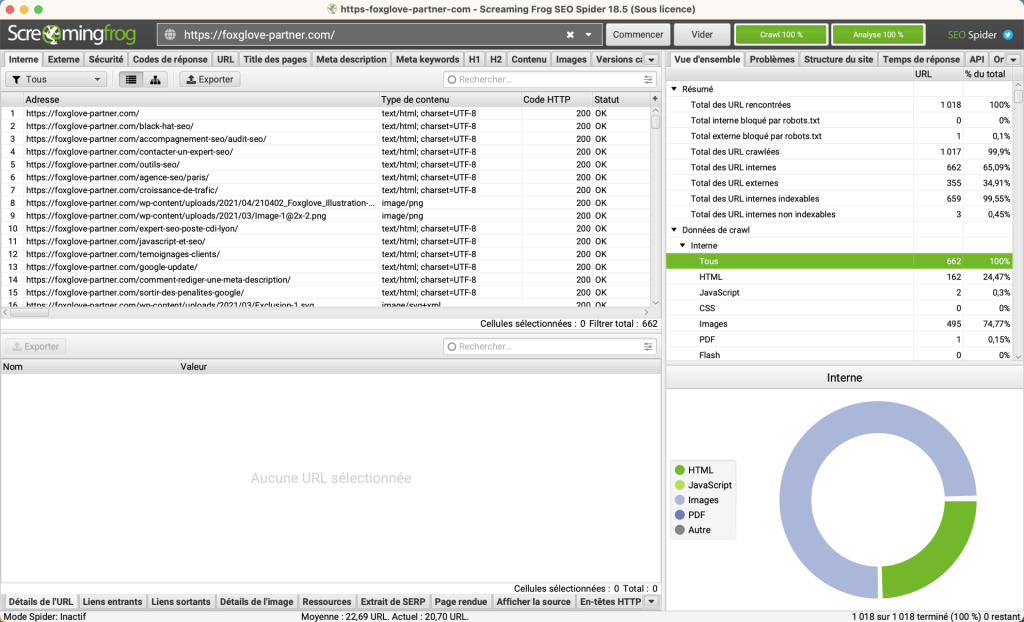

Screaming Frog est sans conteste le meilleur outil répondant à la première catégorie. Mais attention, nous vous recommandons au moins 16 Go de mémoire vive, tant la place sur votre RAM peut vite s’accélérer. Heureusement vous pouvez le configurer pour qu’il stocke vos données en partie sur le SSD.

Avec Screaming Frog, vous pouvez constater en local sur votre ordinateur de nombreux points de corrections possibles : erreurs 404, éléments ralentissants l’indexation comme des redirections 301, balises de titres manquantes réduisant de facto la qualité perçue… Bien entendu, nous ne venons que développer des exemples superficiels. On pourrait écrire un livre dessus, tant cet outil est complet.

Oncrawl remplit de son côté les mêmes fonctions d’audit SEO, mais sous la forme d’une plateforme SaaS. C’est donc un site qui vous propose ses fonctionnalités sous la forme d’un abonnement mensuel ou annuel. Ainsi vous ne consultez pas ces informations sur un logiciel à part, mais sur des pages web. C’est un excellent complément à Screaming Frog. Le grand avantage d’Oncrawl, c’est qu’il est décorrélé de la puissance de votre ordinateur et de la vitesse de votre connexion internet.

Enfin, il existe un autre crawler en ligne spécialisé dans l’audit SEO technique d’un site : Botify. Si à première vue il semble assez similaire à Oncrawl, il se révèle dans la pratique beaucoup plus performant et précis. Toutefois il y a un prix à payer, puisque c’est de loin l’outil le plus coûteux du marché. Chez Foxglove, nous l’utilisons en parallèle de Screaming Frog, car il nous permet d’aller plus loin que ses concurrents sur certains aspects techniques.

La Search Console

Heureusement, il n’y a pas que des outils payants ! La Search Console est une solution gratuite, directement fournie par Google lui-même. Elle vous donne de précieuses informations sur la manière dont le moteur de recherche perçoit votre site, ce qui le rend indispensable. Si elle ne permet pas de faire un audit SEO sans aucune autre ressource, apprendre à l’exploiter peut vous aider grandement.

A travers la Search Console, Google vous envoie directement des alertes dès qu’il y a un problème d’ordre technique : mise à jour du robots.txt qui bloque l’accès à certaines pages, erreurs 404 qui apparaissent en cascade, ergonomie mobile défaillante… Vous pouvez également y ajouter directement votre Sitemap, afin d’aider le moteur de recherche dans son exploration.

Vous l’aurez compris, elle fait partie des indispensables si vous souhaitez monitorer vos problèmes techniques jour après jour. Si vous souhaitez rentrer dans les détails, nous avons déjà fait un article de blog vous expliquant comment optimiser votre budget crawl sur la Search Console.

Une myriade d’outils gratuits

Le SEO fédère une communauté de passionnés, proposant parfois des solutions très avantageuses sans débourser le moindre centime. Les extensions de navigateurs en sont un excellent exemple. Faisons le tour sur certains d’entre eux. Nous nous focaliserons uniquement sur Chrome, le plus répandu des navigateurs web.

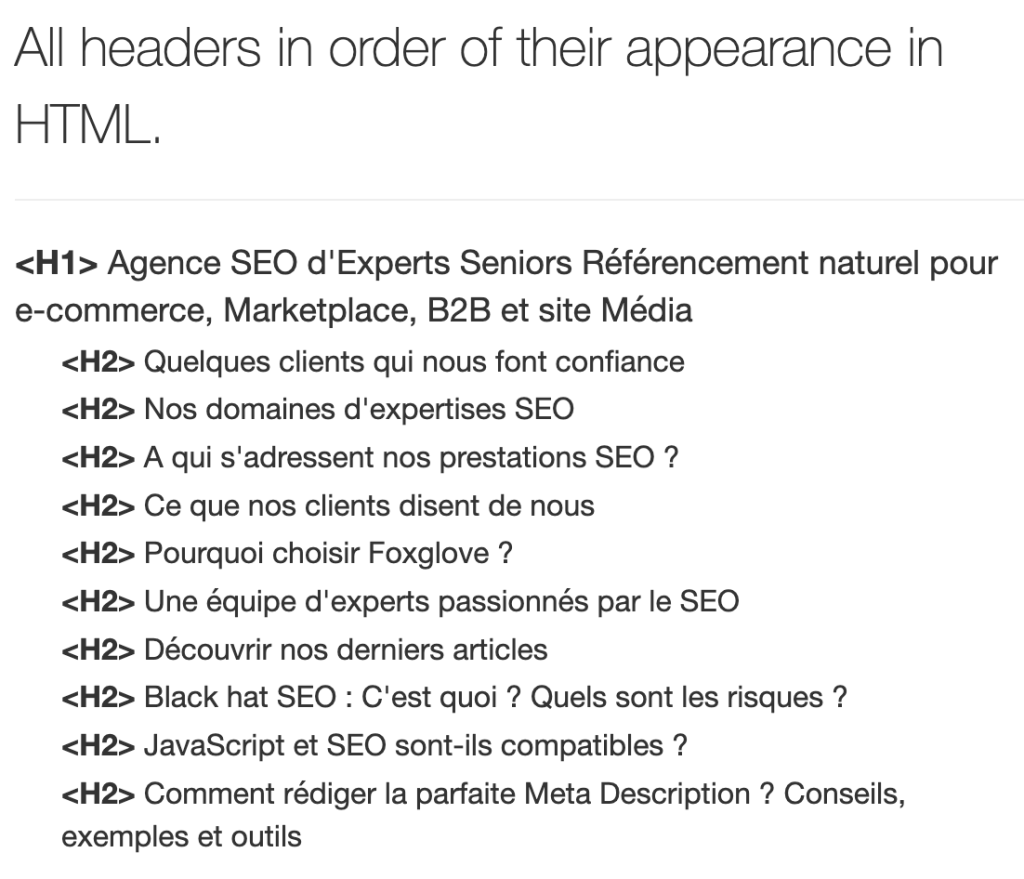

SEO META in 1 CLICK vous donne un aperçu intéressant des balises, notamment la hiérarchisation des Hn :

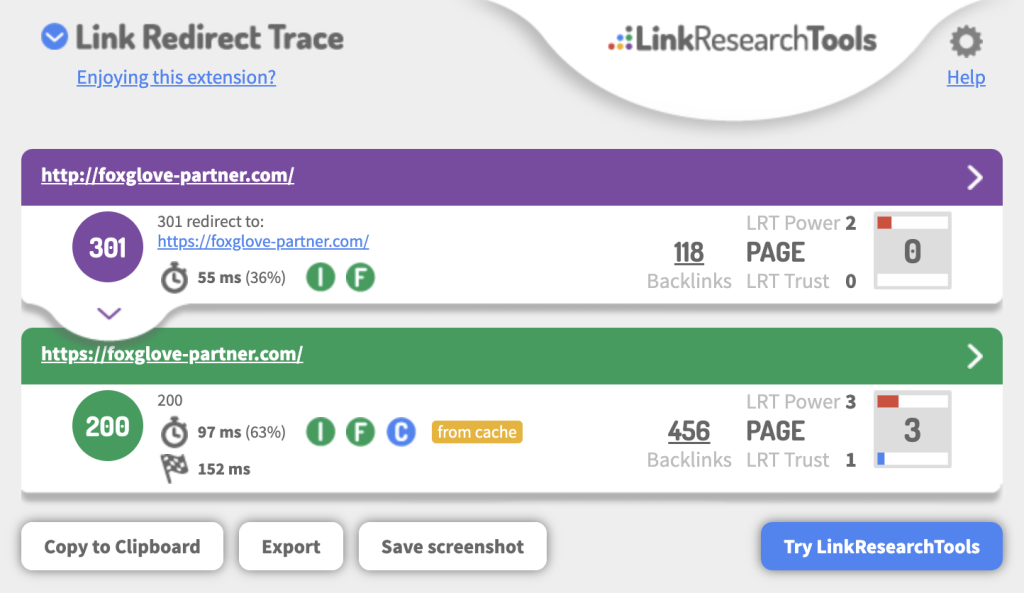

Link Redirect Trace vous montre de manière très visuelle les chemins de redirections, tout en fournissant des informations supplémentaires intéressantes, comme le temps de chargement de chaque page, ainsi que l’indexabilité des pages :

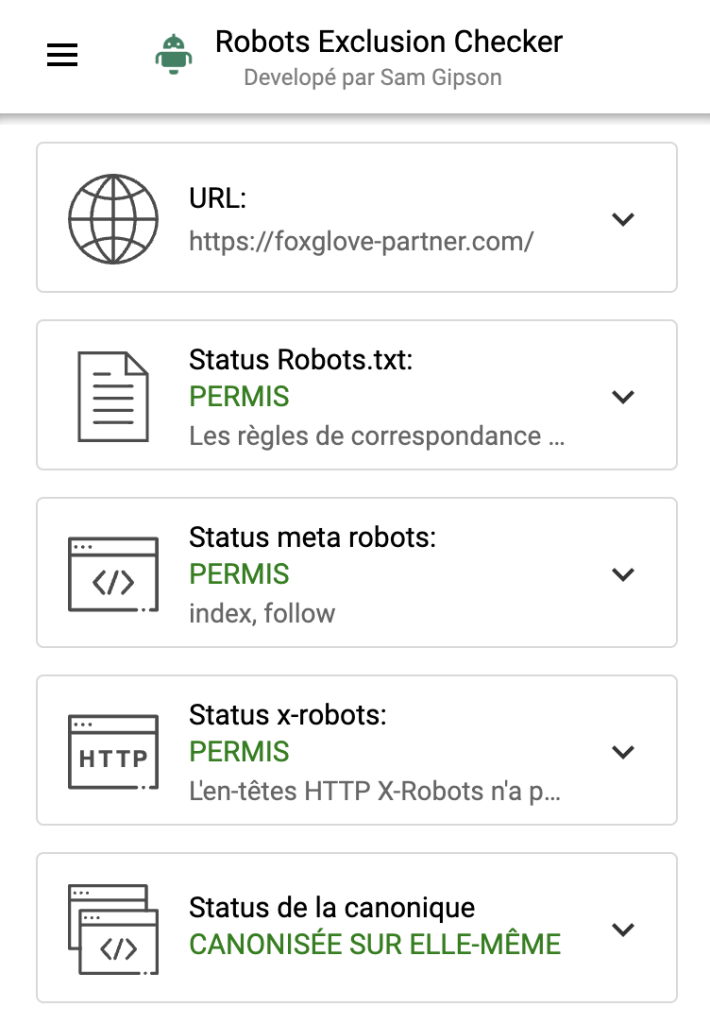

Robots Exclusion Checker se focalise quant à lui sur les différents paramétrages pouvant nuire à l’indexation de vos pages. Robots.txt, balise noindex, URL canonique, tout est vérifié et présenté avec clarté et concision :

Enfin, toujours dans la gratuité, Google vous propose des solutions intéressantes de son côté aussi. Dans le cadre SEO, les plus pertinents sont ses deux outils de test des données structurées et PageSpeed Insights, ce dernier vous donnant des informations sur la performance de votre site et son respect (ou non) des signaux web essentiels, dont l’algorithme tient compte.