Comment fonctionne l’indexation sur Google ?

L’indexation est la pierre angulaire du SEO. Nos experts partagent leur méthode pour augmenter le trafic SEO des sites e-commerces, marketplaces et médias.

Comment fonctionne le moteur de recherche ?

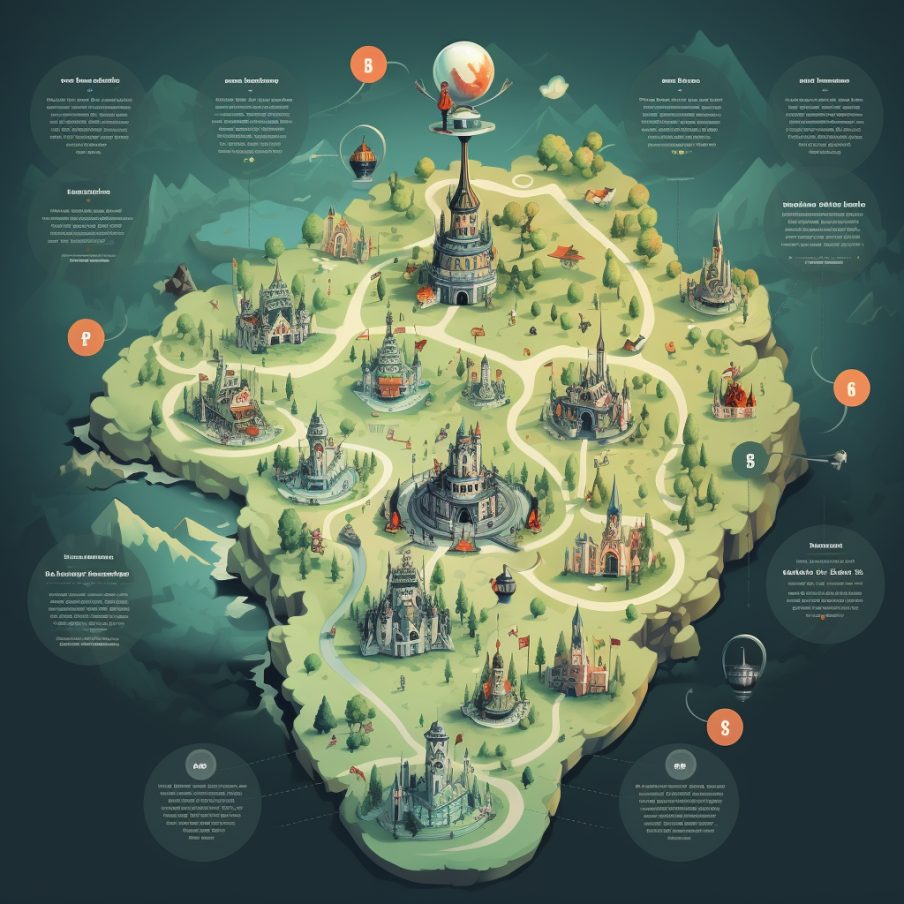

Voici les 4 étapes du fonctionnement global de Google :

- Crawl des url du site

- Indexation

- Algorithmes de ranking

- Affichage dans la page de résultat (SERP)

Les résultats proposés par Google suite à une requête ne sont pas ceux du site. Les pages proposées correspondent à la copie des pages originales. L’indexation est l’étape qui permet à Google de répliquer dans sa base de donnée le contenu des pages du site. Si une page n’est pas indexée, elle n’apparait pas dans le moteur de recherche.

Crawl

Google a donc besoin de découvrir les pages (url) à copier dans son index. Cette étape se fait grâce aux Googlebots. Ces robots vont découvrir les pages grâce aux liens présents dans la page (corps du texte, menu, footer). Ils vont suivre ces liens et copier le contenu de l’url sur laquelle ils arrives. Et ainsi de suite durant un temps limité (le budget crawl).

Vous pouvez choisir de bloquer certaines pages en refusant leur indexation. Cela peut être le cas pour les pages sans intérêt SEO (mentions légales par exemple).

Indexation

C’est l’étape d’enregistrement du code dans la base de donnée du moteur de recherche. Cette étape va permettre de classer et d’organiser les contenus dans la base de données Google. L’organisation de la base doit permettre d’afficher des pages pertinentes pour répondre aux différentes requêtes.

Il existe 2 index chez Google. L’index principal qui regroupe les pages les plus intéressantes. Et l’index secondaire dédié aux pages de moins bonne qualité aux yeux de Google. Les pages présents dans ce second index sont souvent des pages au contenu dupliqué.

Algorithmes de classement

De nombreux algorithmes cohabitent et sont régulièrement mis à jour par Google. Leur but est d’aller chercher dans l’index les résultats les plus pertinents et de définir leur ordre d’affichage. Ces algorithmes visent à apporter la meilleure réponse à l’internaute. Celui-ci doit trouver dès les premiers résultats la réponse à sa question.

Affichage des résultats

La SERP (Search Engine Response Page) permet d’afficher les url les plus pertinente. Depuis plusieurs années, Google travaille à améliorer l’affichage des résultats pour faciliter le choix de l’internaute. Notamment au travers des positions 0, PAA (People Also Ask) ou des sitelinks.

L’index Mobile first en septembre 2020

Google l’a annoncé depuis longtemps, à partir de septembre 2020, tous les sites seront crawlés dans leur version mobile. Auparavant, seule la version desktop existait. Puis les versions mobile et desktop ont cohabitées. Maintenant, la version « par défaut » d’un site est sa version mobile. Cette mise à jour a débuté depuis longtemps mais à partir de septembre, tous les sites seront concernés.

Cela a plusieurs conséquences :

- Si le contenu mobile n’est pas identique au contenu desktop, vous allez perdre un certain volume de mots clés et donc de trafic

- Le Googlebot va suivre les liens proposés pour la version mobile. Si le maillage ou les menus ne sont pas identiques, l’exploration ne se fera pas à iso périmètre

L’indexation est fondamentale pour le SEO. Assurez-vous bien d’être prêt pour cet update d’algorithme.

Le Budget Crawl

Google n’indexe pas 100% du web. Il y a une part extrêmement importante des url qu’il ne connait pas. Afin de découvrir au mieux les url pertinente, Google va allouer à chaque site un temps d’exploration : le budget crawl. Découvrir les pages d’un site et les indexer coûte cher à Google. Il va donc allouer un temps de crawl plus ou moins long en fonction de sa confiance dans le domaine.

L’utilisation du budget crawl est un sujet essentiel pour les sites qui possèdent une forte volumétrie de pages. En effet, un site composé de quelques centaines ou millier de pages n’aura pas de problème. Le bot découvrira les pages et elles seront sans doute toutes indexées. Ce ne sera pas le cas pour les sites plus importants. Les sujets d’optimisation du budget crawl sont pertinents pour les sites à partir de 10 000 url. Le Googlebot va venir sur le site et le parcourir en plusieurs fois pour n’en connaitre au final qu’une partie (taux d’indexation). Il est donc fondamental que vous fassiez découvrir vos pages stratégiques en priorité.

Le sitemap

Un Sitemap est un fichier au format XML qui contient une liste d’URLs qui pourra être utilisée par les moteurs de recherche pour découvrir les pages d’un site.

Pour être efficace, un Sitemap doit être “propre”, et ne contenir que des pages stratégiques ou des nouvelles pour faciliter leur indexation.

Le Sitemap est utile pour guider les robots de Google dans leur exploration des URLs du site. Il est donc important de vérifier qu’il est régulièrement mis à jour afin de refléter la réalité du site.

L’indexation, enjeu majeur du SEO technique

Plus la taille du site est importante, plus la partie technique du SEO sera clé dans la performance. En effet, seules les pages indexées sont présentées dans les SERP. Une page dont le contenu est optimisé mais qui n’est pas découverte et indexée ne pourra donc pas générer de trafic. Dès lors, vous devez travailler votre SEO pour améliorer votre taux d’indexation des pages stratégiques.

Si votre site est important en terme de nombre de pages, voici les principales étapes pour améliorer votre performance SEO :

- Indexabilité : s’assurer que vos pages stratégiques sont bien indexables (que rien n’empêche leur indexation) et prédominantes dans la structure du site

- Crawlabilité : s’assurer que vos pages stratégiques peuvent être crawlées facilement et efficacement par Google

- Optimisation : améliorer la qualité perçue de vos pages en les optimisant en fonction des exigences d’algorithmes pour qu’elles génères plus de trafic

La première étape consiste donc à s’assurer qu’un maximum de pages du site sont bien indexables. Nous suivrons donc le taux de pages indexables et les raisons de non indexabilité. En SEO, une page indexable est appelée compliant et répond aux exigences suivantes :

- Ne comporte pas de tag NoIndex

- Sans balise canonique pointant vers une autre url

- Répond dans un code http 200

- Correspond à un fichier text/html

Les outils SEO de crawl comme Botify vont permettre d’explorer votre site et d’identifier ces informations. Pour optimiser l’indexation, il faudra mener des actions correctives sur l’ensemble de ces éléments. Vous devrez notamment analyser les mauvais codes http comme les redirections 3xx, les pages inaccessibles 4xx et les erreurs serveurs 5xx.

De trop nombreux SEO se concentrent sur les critères onpage et l’optimisation de contenus. C’est bien évidemment une part importante du métier mais elle ne peut se faire sans s’assurer que les pages sont bien indexables, crawlées et indexées.