Pour optimiser le budget crawl, vous devez guider le Googlebot dans le labyrinthe de vos pages

Définition

Le budget crawl est le temps accordé par Google à la découverte et l’indexation des URLs d’un site internet. Contrairement aux idées reçues, Google ne connait pas toutes les url d’un domaine. Il accorde à chaque site un temps pour que les bots parcourent les URLs et en copient le code (indexation). Au-delà de ce temps, le Googlebot arrête son exploration, qu’il ait ou non découvert l’intégralité du site.

Une page non indexée ne peut pas se positionner dans les pages de résultat de Google (SERP) et générer du trafic. Il est donc fondamental d’être certain que vos pages stratégiques soient bien indexées.

Le risque étant que le temps de crawl ne permette pas la découverte de l’intégralité du site. Dans ce cas, comment faire en sorte que vos URLs les plus intéressantes soient découvertes en priorité ?

Les sites web concernés

Le budget crawl et son optimisation sont donc très importants pour les sites avec un nombre de pages importantes. Au-delà de 10 000 URLs, il est fondamental d’analyser et de suivre l’utilisation faite du budget crawl. Vous devrez donc collecter et analyser les logs qui indiquent pour chaque url du site la date et l’heure du dernier crawl.

Le risque pour les sites à forte volumétries de pages, est que Google perde du temps à crawler et indexer des pages qui ne génèrent que peu de trafic. Il n’aura plus de temps pour visiter certaines pages qui pourraient générer davantage de visites.

L’optimisation du budget crawl est un des enjeux majeurs pour :

- les sites e-commerces

- les marketplaces

- les sites média

Ce sont des typologies de sites qui peuvent regrouper plusieurs centaines de milliers voire plusieurs millions de pages. Le taux d’indexation est donc un sujet majeur pour la performance SEO.

Comment optimiser votre budget crawl ?

Dans un premier temps, il faut s’intéresser à la performance SEO de vos pages. Toutes vos pages ne génèrent pas de visites SEO. Il y a donc des écarts de performance. Le point de départ est de découper votre site en groupes de pages homogènes. Pour un site e-commerce, nous pouvons identifier :

- La homepage

- Les pages de catégories

- Les pages produits

- Les pages de pagination

- Les pages édito

Nous pouvons visualiser la performance de chacun de ces segments. Cela permet de se rendre compte que certaines typologies de pages ne génèrent que très peu de trafic. Cependant, le nombre élevé d’URL va consommer une part importante du crawl budget du site. A contrario, peut être que certains types de pages plus performants ne sont pas intégralement indexés.

Les optimisations techniques pour un meilleur usage du budget crawl

Structure et URLs Compliant

Pour optimiser votre budget crawl, vous allez analyser la structure de votre site avec un crawler comme Botify. L’objectif est de présenter à Google des url compliant dans une structure propre. Nous allons donc nettoyer la structure afin de réduire au maximum les pages Non Compliant. Une URL non indexable est peu susceptible de générer du trafic SEO.

Plusieurs raisons peuvent rendre une URL Non Compliant :

- La présence d’une balise noindex dans la page

- Un mauvais code http (erreurs 301, 302, 404 et 500)

- Une balise canonique renvoyant vers une autre page

- Que la page ne soit pas au format Text/html

Pour chacune de ces raisons, le bot va perdre du temps à charger le code d’une page qu’il ne doit pas indexer. Cela pénalise l’usage du crawl budget de votre site.

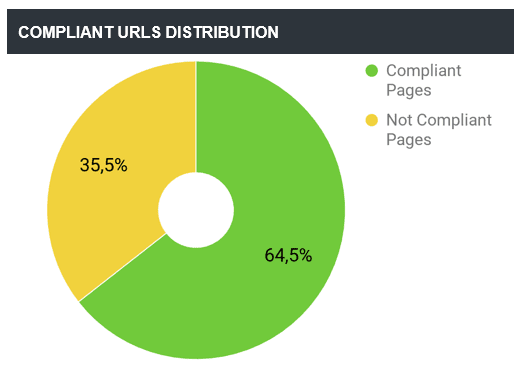

Dans l’idéal, la structure de votre site doit avoir 100% d’URL Compliant. Voici un exemple de rapport Botify sur le taux d’URL Compliant (indexables) :

Pour éviter que Google perde du temps sur des pages inutiles ou qui ne lui sont pas destinées, le robots.txt peut être très utile.

Vitesse de chargement du code html

Plus votre code html va charger rapidement et plus Google pourra découvrir d’URL dans le temps de crawl qu’il alloue à votre site. Il est donc fondamental, au-delà de la vitesse d’affichage pour l’internaute, de s’intéresser à la vitesse de chargement côté Google. Google préconise un temps de chargement en dessous de 500ms. Les pages qui répondent en plus de 2000 ms subissent une pénalité algorithmique. Il est donc nécessaire de suivre et piloter la vitesse de chargement des pages. Notamment de vous assurer que les pages stratégiques (susceptibles de générer le plus de trafic) répondent en moins de 2 secondes.

Contenus dupliqués

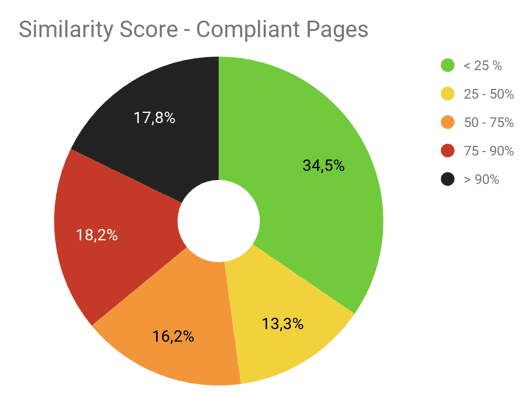

Les pages Compliant dont plus de 90% du contenu est similaire avec d’autres pages sont considérées comme des contenus dupliqués. Ces pages dupliquées entre en concurrence dans les SERPs sur les mêmes requêtes. La performance SEO est donc moins bonne car diluée entre plusieurs URLs.

D’autre part, les contenus dupliqués ne présentent aucun intérêt pour Google. La découverte de ces pages est donc une perte de temps. Il en résulte que Google a tendance à crawler moins efficacement les sites avec des contenus dupliqués.

Voici un exemple d’analyse du score de similarité entre les pages d’un site :

Des actions techniques vont être mises en place pour éviter de présenter les URLs dupliquées à Google.

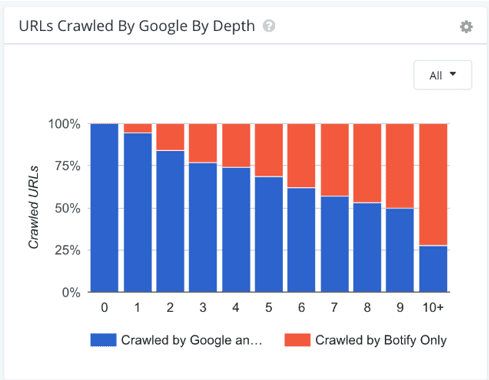

Profondeur du site

Avec un budget crawl limité, Google va découvrir en premier les pages les plus hautes dans la structure. Plus vos pages sont profondes et moins elles ont de chance d’être indexées. Voici un graphique qui présente le taux de crawl en fonction de la profondeur du site :

En SEO, il est souvent conseillé d’avoir une profondeur maximale de 4 dans un site.

KPI à suivre pour optimiser votre performance SEO

Voici quelques KPI techniques qui sont pertinents pour piloter et optimiser l’usage de votre budget crawl :

- Le taux de pages Compliant dans la structure du site

- Le ratio visites / nombre de pages pour chaque segment

- Le taux de crawl des pages compliant

- La vitesse moyenne de chargement

- Le taux de contenus dupliqués

- La profondeur moyenne de vos pages

Les experts Foxglove sont là pour vous accompagner dans l’optimisation SEO de l’utilisation de votre budget crawl. Ils sont habitués à travailler sur des analyses de logs via les outils Botify. Ils sauront faire les meilleures préconisations à vos équipes sur ces sujets de SEO technique.