La technique, un mécanise à bien huiler pour votre SEO

Le SEO technique, base de la pyramide SEO

L’étude du SEO technique est si vaste qu’il s’avère nécessaire de faire un audit complet du domaine.

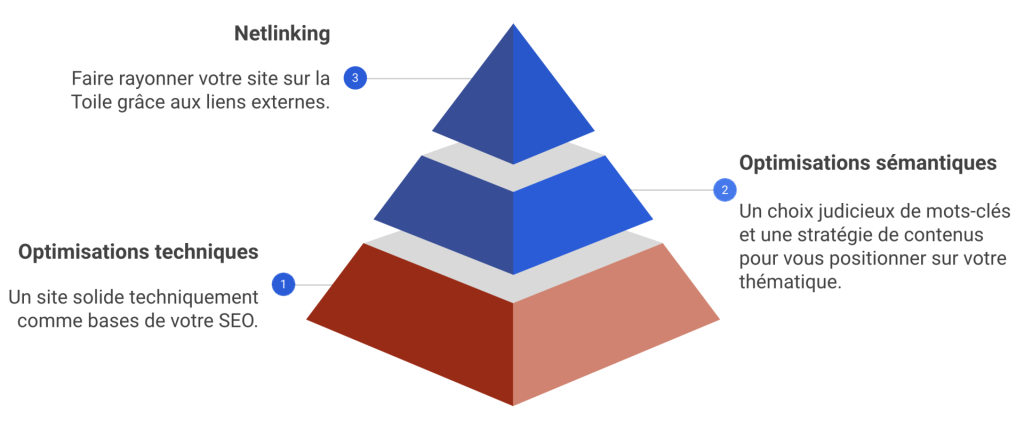

Il est fréquent de distinguer 3 catégories d’optimisations SEO :

- le SEO technique,

- l’optimisation sémantique,

- le netlinking.

Chacune de ces « spécialités » de référencement naturel correspond à un domaine d’expertise à part entière. Nous avons l’habitude de parler de la pyramide SEO avec :

- comme base : la technique

- au-dessus la sémantique

- et enfin le netlinking

Plus le site est dense en nombre de pages et plus la technique est importante. Un audit SEO technique est donc essentiel pour les E-commerces, les marketplaces et les sites médias. En effet, si le site n’est pas optimal techniquement, les moteurs de recherche ne verront pas correctement vos URLs importantes. Il ne pourra pas les indexer et les faire performer dans les SERP. La technique n’est pas une option, mais un pré-requis nécessaire.

Pourtant, de très nombreux sites web possèdent des faiblesses techniques importantes. Il s’agit d’un sujet central pour votre performance SEO.

Indexabilité du site

L’analyse et les recommandations SEO à travers un audit visent à s’assurer qu’un maximum d’URL stratégiques soient bien indexables pour les moteurs de recherche. Il s’agit de vérifier que la structure du site est propre et que les pages importantes sont prédominantes. L’outil Botify permet notamment d’identifier :

- des pages peu susceptibles de générer du trafic organique

- des URLs pouvant faire perdre du temps de crawl à Google au détriment des pages importantes

- les liens pointant vers des pages qui diluent le PageRank

Le travail technique initial va donc consister à nettoyer la structure du site. Ce nettoyage des pages non indexables va permettre d’utiliser au mieux le budget de crawl, maillon central de votre stratégie de référencement naturel.

Pour cela, vous analyserez les raisons de non indexabilité de vos URL :

- les pages en NoIndex

- les mauvais codes HTTP (erreurs 404, redirections 301, redirections 302 …)

- les URL qui renvoient vers d’autres URL via les balises canoniques

Crawlabilité

Les robots de Google ont des ressources limitées pour explorer l’ensemble du web. Ce temps est appelé budget de crawl ou crawl budget et n’est pas suffisant pour les sites web importants (plus de 10 000 URL). Le SEO va donc mettre en place une stratégie pour s’assurer que le contenu le plus important soit bien crawlé. Le risque étant que les Googlebots parcourent des URLs non prioritaires au détriment de vos pages stratégiques. L’analyse de logs va donc permettre d’identifier et suivre le parcours et la fréquence de passage des robots de Google. Vous pourrez ainsi connaître le taux de crawl des différents segments de votre site internet.

Pour améliorer la crawlabilité du site, vous devrez optimiser sa structure mais également suivre la vitesse de chargement du code HTML. Plus le code se charge vite et plus Google pourra découvrir de pages avec le budget de crawl qu’il alloue à votre site.

Le fichier sitemap est également important car il aide les moteurs de recherche à mieux découvrir vos URLs. Le fichier sitemap doit être propre et ne contenir que des pages stratégiques ou les nouvelles URLs dont vous voulez faciliter l’indexation.

Un contenu dupliqué va également impacter la crawlabilité du site. En effet, vos pages vont se positionner sur les mêmes requêtes et se cannibaliser. De plus, le moteur de recherche va crawler moins efficacement un domaine victime de contenus dupliqués. Pour améliorer la crawlabilité de votre site web, vous devez donc inclure le score de similarité dans votre stratégie de référencement naturel.

Les pages orphelines sont non linkées dans la structure du site, ce qui les rend inaccessibles à un crawl. Elles consomment du budget de crawl mais ne bénéficient pas du PageRank qu’apporte le maillage interne. Il est donc important d’identifier les pages orphelines importantes qui génèrent des visites via les liens externes. Elles doivent être linkées à nouveau dans la structure. Si ces pages ne sont pas stratégiques, il faut les supprimer afin de bloquer le crawl des robots de Google et d’éviter les pertes de budget de crawl.

La navigation a pour objectif de permettre une découverte efficace de votre arborescence. Mais ce n’est pas tout, le maillage interne va également permettre la diffusion du PageRank. Le SEO technique aura donc également pour objectif d’optimiser les 3 types de navigations :

- navigation descendante (menu)

- navigation ascendante (fil d’ariane)

- navigation horizontale

Optimisation mobile

Nous sommes à l’époque du Mobile First Index, c’est-à-dire que les pages sont évaluées par Google en fonction des critères mobiles et non plus desktop. Vous n’avez donc pas le choix, votre site doit être adapté aux mobiles, ne serait ce que pour une raison d’expérience utilisateurs. Le test Mobile Friendlyness de Google évalue si les éléments de votre page sont adaptés à la navigation mobile. Dans le référencement web, nous parlons souvent de compatibilité mobile, tant cette question est devenue centrale pour tous les moteurs de recherche du web.

La vitesse de chargement mobile côté internaute est également un stratégie SEO technique pour de nombreux sites web. Difficile de connaître l’impact réel de ce critère dans l’algorithme. D’un point de vue utilisateur et conversion, c’est un critère important. L’outil PageSpeed Insights développé par Google est extrêmement bien fait. Vous n’avez plus qu’à suivre les recommandations qui vous sont formulées.

Optimisation on-page

Lorsque l’on parle de critères on-page, nous pensons bien évidemment aux balises HTML et à l’arborescence. Notamment le contenu des Title et H1.

Chaque page étant optimisée pour une requête cible, les balises Title et H1 doivent être uniques. D’une manière générale, il faut réduire au maximum le nombre de balises inexistantes ou dupliquées. Cette partie est la plus simple. L’essentiel est qu’elles soient optimisées pour le bon mot-clé. Il est donc important d’analyser les pages pour lesquelles le top keyword n’est pas dans la balise Title ou H1. La page se positionne mieux sur une requête, il est donc intéressant de regarder s’il ne faut pas modifier le balisage. Cela permettra de gagner des positions dans la SERP.

La balise meta description n’a pas d’impact direct en SEO. Mais son contenu va impacter le taux de clic dans la page de résultat. Il est donc important d’un point de vue référencement web de l’optimiser avec une préoccupation particulière sur la qualité syntaxique.

Les optimisations on-page sont à la limite entre la technique et la sémantique. De nombreux outils existent pour identifier les balises manquantes ou dupliquées. Une analyse plus fine est nécessaire pour vraiment optimiser ce volet on-page du SEO.

La vitesse de chargement

Un site qui charge vite et bien est un critère dont Google tient compte. D’une part parce qu’un site trop lent agace les internautes, d’autre part parce que chaque milliseconde qui passe est du temps consommé pour ses robots d’exploration. Il y a donc une règle d’or que l’on peut appliquer à n’importe quel site de la Toile : les pages ne doivent pas mettre plus de 2 secondes à charger, afin d’éviter de recevoir une pénalité algorithmique. L’idéal à atteindre est un site qui charge chacune de ses pages sous les 500 ms, autrement dit une demi-seconde.

Pour évaluer les performances d’un site, Google ne se contente pas juste de regarder son temps de chargement total. Il décompose ce processus en plusieurs métriques, les plus importantes étant les signaux Web essentiels. Combien de temps votre page a-t-elle besoin pour afficher l’élément le plus visible ? Quel est le délai entre une première interaction sur votre page et la prise en compte effective de celle-ci ? Pendant quelle durée existe-t-il un décalage de mise en page pendant le temps de chargement ? Ces signaux, comme d’autres, permettent à Google de juger si votre site est bien optimisé sur ce plan, et convivial pour l’utilisateur.

Données structurées

Les données structurées sont intéressantes car elles peuvent permettre d’apparaître dans les résultats enrichis (Rich Snippets). Ces résultats enrichis apportent plus de visibilité dans la SERP. Ce contenu supplémentaire amène donc davantage de trafic organique qualifié.

Il est intéressant d’analyser l’utilisation des données structurées faites par vos concurrents. En fonction de votre secteur d’activité, vous n’aurez peut-être pas le choix ! Il peut parfois constituer un avantage concurrentiel dans la page des résultats de recherche.

Vous retrouverez les différentes données existantes et la manière de les intégrer sur Schema.org.