Que nous réserve cette mise à jour majeure de l’algorithme de Google ?

L’intelligence artificielle, en particulier générative, n’est pas juste un buzzword. La presse généraliste s’empare de plus en plus souvent de problématiques qui n’intéressent d’habitude que les référenceurs et leurs clients. Il paraît que les résultats de recherche sont de moins en moins pertinents, et les utilisateurs s’en rendent compte. Avec la multiplication exponentielle des contenus générés sur ChatGPT et les autres, la situation peut effectivement devenir critique.

Alors Google tape du poing sur la table et sort deux mises à jour majeures le même jour : la Core Update et la Spam Update. Annoncées le 5 mars, nous avons préféré prendre une semaine de recul avant de vous en parler, pour voir qui sont les premiers gagnants et les perdants de cette grande loterie, mais aussi une première conclusion sur les effets ressentis.

Que dit officiellement Google de la Core Update et la Spam Update ?

L’objectif affiché publiquement par Google est très clair : il souhaite lutter contre le contenu non original et de faible qualité. Concernant la mise à jour anti-spam, elle est en partie tournée vers la production de contenu à grande échelle, mais pas que !

Faisons un important rappel : ce paragraphe se centre sur le discours officiel de Google. Nous mettons donc en avant sa communication, et non les effets concrets constatés par les référenceurs. Cet aspect sera développé lors du paragraphe suivant.

Google prévoit que 40% des pages web présentant des textes de mauvaise qualité disparaissent du top 10 des résultats de recherche. C’est très ambitieux et cela peut totalement rebattre les cartes pour certains sites web. De nouveaux signaux sont déployés pour analyser si un contenu est utile ou non, mais nous ne connaissons pas les détails à l’heure où nous écrivons ces lignes.

La Spam Update est elle aussi une mise à jour majeure, car elle s’attaque à de très nombreuses failles connues de l’algorithme. Cela nous rappelle, si besoin est, que les techniques Black Hat ne fonctionnent que sur un temps limité.

La Spam Update lutte contre plusieurs techniques controversées des référenceurs :

- La génération de contenu de faible qualité à grande échelle (IA comme humaine)

- La manipulation de ses algorithmes à travers les domaines expirés

- L’utilisation trompeuse de la réputation d’un site

- Une dépréciation de l’impact des backlinks (sans que cela n’élimine l’intérêt du netlinking)

Le premier point s’inscrit dans la continuité de la Core Update et est particulièrement d’actualité. C’est une évolution logique après la mise à jour du Helpful Content Update en septembre dernier.

Pour ce qui est des domaines expirés, cette annonce va donner des sueurs froides à plus d’un référenceur. La réutilisation de noms de domaines qui bénéficiaient d’une forte notoriété avant la disparition du site était une méthode très efficace pour booster un site de la même thématique. L’heure de la fin de la récréation a sonné.

L’abus de la réputation d’un site s’articule sur une logique plus interne. Elle vise les pages tierces d’un site quand celles-ci ne sont pas directement créées par l’éditeur. Cela comprend les contenus sponsorisés. Pas tous bien sûr, mais principalement ceux qui n’ont pas de rapport avec le site hôte. Notez que Google vous laisse le temps de corriger cela d’ici le 5 mai 2024.

Enfin, nous sentions le vent tourner à ce sujet, et Google l’officialise de plus en plus : les liens externes perdent une nouvelle fois de leur importance dans le calcul du positionnement d’un site. Cette dépréciation est une sorte d’aveu d’échec. Après toutes ces années, le moteur de recherche avoue à demi-mots sa difficulté à lutter contre les liens spammy… S’il est encore loin le temps où toute stratégie linking doit être abandonnée, il n’en demeure pas moins que les backlinks ne font plus partie du top 3 des signaux.

Quels effets concrets pouvons-nous déjà ressentir ?

Les résultats sont contrastés. La semaine écoulée fut quelque peu mouvementée pour certains gérants de sites web. Prendre du recul sur nos conclusions est important, car certains ont vu leur trafic SEO quasiment disparaître les trois premiers jours, puis revenir à 50% du niveau d’avant… D’autres n’ont pas eu cette chance et stagnent toujours dans les confins des résultats de recherche.

Pour autant, est-ce que Google est parvenu à réduire 40% des résultats polluants ? Il est impossible de répondre à cette question pour l’instant, d’autant plus que la mise à jour se déploie sur le mois entier, comme toute update majeure de Google…

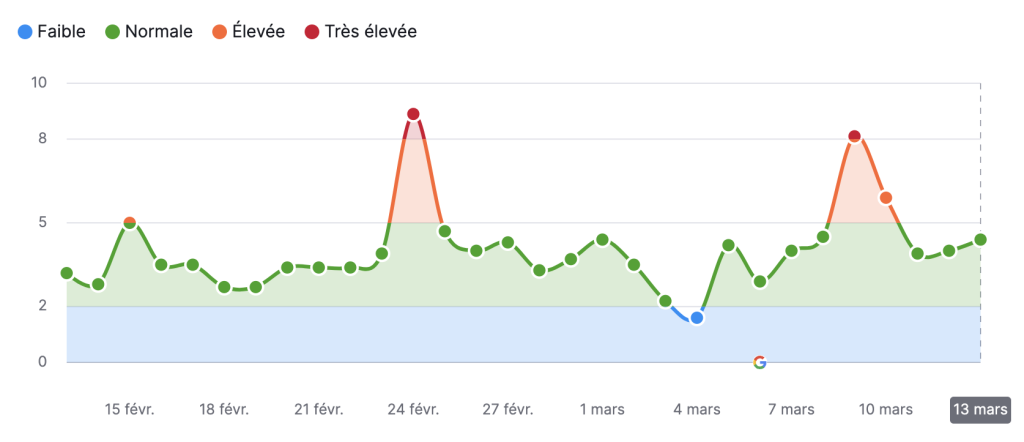

Quand nous regardons la volatilité des SERP depuis l’outil Semrush Sensor, nous voyons effectivement sur le territoire français un net bouleversement les trois premiers jours, avant de se rétablir :

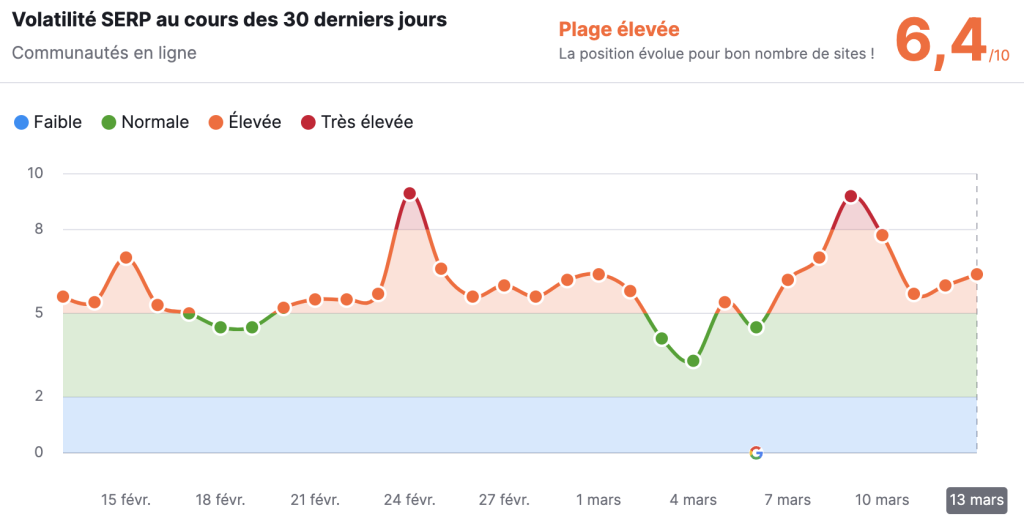

Toutefois, certaines catégories de sites sont plus impactées que d’autres. Les communautés en ligne sont très touchés, en particulier Twitch qui a sévèrement dévissé :

Ian Nuttal, figure éminente de la communauté SEO, a analysé 50 000 sites pour déterminer de manière globale les mouvements de la SERP au cours de cette dernière semaine. Sur 49 345 sites surveillés, 837 ont été entièrement supprimés de l’index de Google. Cette mesure radicale concerne mine de rien 1,7% de cette cohorte, ce qui est beaucoup en 7 jours.

Ces sites désindexés couvrent plusieurs catégories et sont liés à des régies publicitaires très diverses, ce qui montre bien une vaste portée des actions de Google. Toujours d’après Nuttal, les 837 sites représentaient plus de 20 millions de visites organiques mensuelles.

Tous les sites concernés par la désindexation partagent un point commun : 100% présentaient des signes de contenu généré par l’IA, la moitié ayant la quasi-totalité de leurs publications issues d’outils comme ChatGPT. Cela démontre que le visage des SERP change à vitesse grand V, et que ce n’est pas pour rien que Google parlait de Core Update.

Qu’est-ce que cela préfigure pour l’avenir du SEO ?

Si nous prenons un peu de recul, nous voyons certes de grands bouleversements dans les SERP, mais pas toujours pour de mauvaises raisons. Si comme nous, vous vous inscrivez dans une démarche de création de contenus qualitatifs, c’est une bonne nouvelle. Les éditeurs de sites peu scrupuleux qui trustaient de bonnes places malgré la génération de textes à la truelle disparaissent, au profit de ceux qui réfléchissent vraiment à proposer de la valeur ajoutée aux internautes.

C’est bien aussi pour les utilisateurs de Google, qui déploraient une baisse de la qualité des résultats de recherche. Or sur le long terme, nous avons besoin de la confiance de nos précieux visiteurs. Il est donc évident que malgré cette entrée dans l’ère de l’IA, c’est la fin de la fête pour les référenceurs les moins scrupuleux. A terme c’est une juste récompense pour tous ceux qui veulent bien faire les choses.

Enfin, cela nous rappelle l’importance de ne pas exploiter sans prudence les failles de l’algorithme. Il tombe sous l’évidence que Google connaît depuis des années le phénomène des domaines expirés. Il a eu besoin de temps, mais il a apporté une réponse adaptée à cette indéniable manipulation. Que ce soit votre site ou celui de vos clients, il en va de votre intérêt de penser à long terme. La raison est simple : vous ferez plus de chiffre d’affaires sur des positions stables que sur des fulgurances épisodiques.