Ne piégez pas Google en évitant ces erreurs sur votre robots.txt !

Le fichier robots.txt est aussi simple que puissant. C’est le meilleur moyen de communiquer avec Google, dans sa langue. Vous pouvez ainsi orienter ses robots sur les pages vers lesquelles se rendre, ou d’autres à éviter… Si cela n’empêche pas un Googlebot de “voir” ces pages (au contraire d’une obfuscation), ce tout petit fichier peut changer beaucoup de choses. Ainsi, s’il est mal rédigé, vous pouvez profondément perturber le crawl de votre site !

Voyons aujourd’hui, sur cet article de blog, quelques astuces pour éviter ce genre de problèmes qui peuvent potentiellement ruiner votre SEO.

Petit rappel sur ce qu’est un fichier robots.txt

Nous en avons déjà parlé dans un article dédié, mais revenons brièvement sur ce qu’est un fichier robots.txt. Comme son extension l’indique, c’est un fichier texte tout ce qu’il y a de plus basique. C’est littéralement un document que vous pouvez produire sur le bloc notes de Windows… Toutefois, si vous utilisez un CMS, celui-ci se génère automatiquement, pour le meilleur comme pour le pire.

Son utilité est multiple, car il permet de :

- Contrôler l’indexation : quels répertoires ou fichiers ne doivent pas être indexés par les moteurs de recherche, comme du contenu confidentiel ou des parties du site non publiques…

- Optimiser le crawl : ces instructions aident les robots à ne pas s’éparpiller dans certaines zones du site qui peuvent être des gouffres à budget crawl, notamment les filtres à facettes. Vous pouvez aussi limiter la vitesse à laquelle le robot accède aux ressources du site. Un très bon point pour ne pas surcharger vos serveurs !

- Prévenir le contenu dupliqué : même si les canonicales sont plus adaptées à cette situation, cela peut vous éviter des problèmes de duplicate en ne crawlant pas les pages doublon…

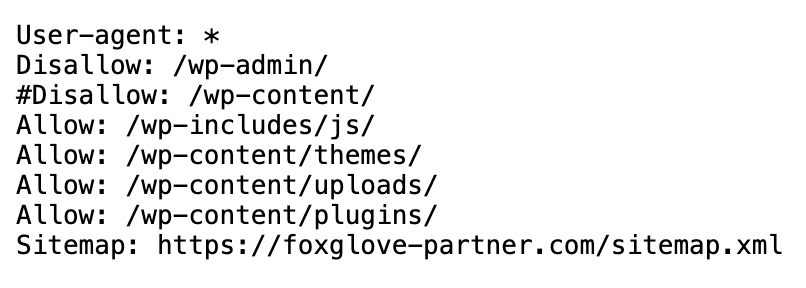

Voici par exemple à quoi ressemble le fichier robots.txt du site Foxglove :

Quelles sont les erreurs les plus courantes ?

Les erreurs sur ce fichier sont monnaies courantes, en particulier si vous développez votre site depuis une feuille blanche. Nous verrons que beaucoup de problèmes peuvent apparaître lorsque vous rédigez vous-même ce fichier. Mais pour autant, ce n’est pas parce que vous avez un WordPress que vous êtes totalement protégé !

Le fichier ne se trouve pas dans la racine du site

Par rapport à une page web classique, les robots d’exploration n’accèdent pas au robots.txt via un lien interne. Ils connaissent déjà l’URL où trouver ce document : example.com/robots.txt. Ainsi vous ne devez pas l’insérer dans un sous-répertoire. Dans le cas contraire, il serait totalement invisible pour Google et les autres.

La règle est claire : seule une barre oblique doit séparer ce fichier de votre nom de domaine. Cela pourrait potentiellement vous obliger à passer par votre serveur FTP. Si vous utilisez un CMS, la question ne se pose pas, le fichier étant installé d’office.

Mal gérer la syntaxe et les règles d’écriture

Au même titre qu’une regex, le robots.txt répond à des règles d’écritures très strictes. Une simple confusion dans un caractère peut le rendre illisible.

Les règles suivent une syntaxe simple :

- Chaque règle est sur une ligne distincte

- Une règle se compose de deux parties : le User Agent et la directive

- Les lignes commençant par # sont des commentaires et sont ignorées

Quelques définitions s’imposent.

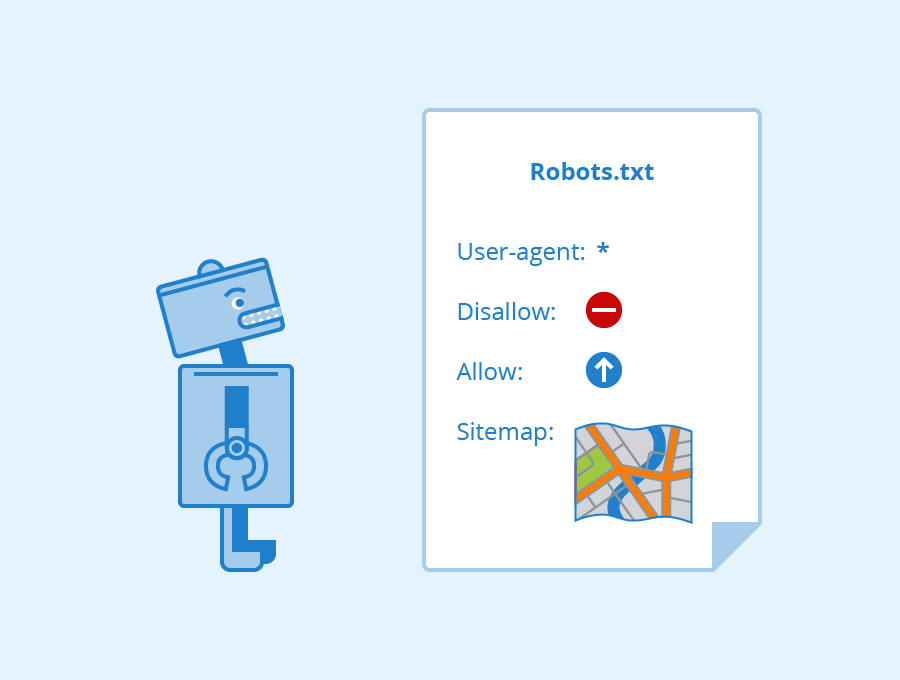

Un User Agent est l’identifiant d’un robot d’exploration. Vous pouvez spécifier le comportement pour tous, ou un bien spécifique.

Une directive spécifie ce que les robots sont autorisés ou non à faire sur le site. Il y en a principalement de deux types :

- Disallow : elle indique les documents ou répertoires que les robots ne sont pas autorisés à explorer. Parmi les exemples les plus courants, figure votre back office, comme le fameux “wp-admin” de WordPress.

- Allow : celle-ci autorise des documents ou répertoires spécifiques de votre site, même quand un Disallow général est défini.

Ainsi le code du robots.txt peut ressembler à cela :

User-agent: *

Disallow: /private/

Allow: /public/

User-agent: Googlebot

Disallow: /restricted/

Dans cet exemple, tous les robots sont autorisés à accéder au répertoire “public”, mais seuls les robots autres que Googlebot peuvent accéder à “restricted”.

Attention à bien respecter la casse : la présence ou non d’une majuscule au début des directives peut déterminer leur prise en compte par les robots ou non.

Empêcher l’indexation de pages importantes pour votre SEO

Comme nous venons de le voir, une mauvaise syntaxe peut bloquer l’indexation de pages importantes de votre site. Mais parfois, il peut aussi arriver que vous rédigiez le fichier en toute connaissance de cause, mais par effet de bord empêchiez la prise en compte de certaines pages essentielles par Google.

Un exemple assez courant d’erreur de ce type concerne les paramètres d’URL. On peut parfois être tenté de toutes les bloquer pour éviter de perdre les robots dans la navigation à facettes de votre E-commerce… Mais si votre pagination se présente aussi sous cette forme, alors vous nuisez au crawl de ces pages. Faites donc très attention !

Nous vous encourageons à utiliser un crawler comme Screaming Frog pour faire remonter toutes les pages bloquées par le robots.txt. Vous risquez d’avoir quelques surprises…

Ne pas spécifier le Sitemap dans votre robots.txt

Il y a une directive que nous avons volontairement tu jusqu’à présent, celle précisant l’emplacement du Sitemap. Ce petit document au format XML a ceci de commun avec le robots.txt qu’il est destiné exclusivement aux robots d’exploration.

Cette directive prend tout simplement cette forme :

Sitemap: http://www.example.com/sitemap.xml

Il est essentiel de le préciser pour une raison très simple. Le Sitemap n’est pas un fichier toujours accessible dans le même répertoire. Par ailleurs, il peut exister plusieurs Sitemap, dans le cadre d’un site multilingue par exemple. Il est donc important que vous guidiez Google en ce sens.

Il ne s’agit pas strictement d’une erreur, mais plutôt d’une optimisation. L’objectif est de donner au Googlebot une longueur d’avance dans sa connaissance de la structure et des pages stratégiques pour votre SEO.

Bloquer les scripts et feuilles de styles

Voilà l’exemple parfait d’une fausse bonne pratique ! Il peut sembler logique de bloquer l’accès à des documents qui ne sont pas des pages HTML indexables. Après tout, le CSS et le JS ne sont utiles que pour l’expérience utilisateur, n’est-ce pas ?

Rien n’est plus faux à notre époque ! Google a besoin de comprendre le design et même les scripts de votre site pour juger de sa pertinence. Ne serait-ce que parce qu’il donne de plus en plus d’importance à l’UX, justement.

En bref, laissez les robots visiter vos URL de scripts et feuilles de styles, afin de prouver à Google la pertinence de votre site.

Utiliser des URL absolues

Dernière grosse erreur, insérer des URL absolues. Au contraire des canoniques et hreflang, Google précise dans sa documentation officielle que rien de garantit que les robots d’exploration interprètent correctement une URL avec votre nom de domaine spécifié dans ce document. Méfiance donc !